L’Université de Montpellier poursuit son engagement en faveur de l’innovation pédagogique avec le projet PAIRSIA (Évaluation par les pairs assistée par l’Intelligence Artificielle), qui s’inscrit dans la continuité du projet Pair’sEval, lauréat de l’AMI « Émergences » en 2021. Ce dernier avait pour objectif de favoriser l’appropriation et le déploiement de l’évaluation par les pairs, notamment dans le cadre de l’Approche par Compétences (APC) et du développement des soft skills des apprenants. Dans cette perspective, lors d’une évaluation par les pairs, les apprenants sont placés dans une posture active en leur permettant d’évaluer les travaux de leurs pairs (Topping, 2009, 2017).

L’IA générative au service d’une évaluation formative

Le projet PAIRSIA va plus loin et intègre une intelligence artificielle générative pour accompagner apprenants et enseignants dans ce processus. L’évaluation par les pairs est reconnue comme un levier d’apprentissage intéressant, qui développe la réflexivité, l’autonomie, la collaboration et la pensée critique (Topping, 2009 ; Tai & Ajjawi, 2018). Cependant, sa mise en œuvre peut être chronophage pour les enseignants et exige une acculturation des apprenants au processus de feedback constructif. PAIRSIA a pour objectif de faciliter cette démarche en exploitant les capacités d’une intelligence artificielle générative. L’évaluation par les pairs devient ainsi plus accessible et plus efficace.

Le projet repose sur l’intégration de l’IA de la plateforme ChallengeMe, déjà disponible au sein de l’environnement numérique de l’Université de Montpellier. L’assistant IA a pour rôle de faciliter l’évaluation par les pairs en proposant :

- Un accompagnement des apprenants dans la production de feedbacks grâce à une IA générative qui analyse leurs évaluations et leur suggère des améliorations.

- Un soutien aux enseignants, via une analyse synthétique des évaluations produites.

Le projet PAIRSIA souhaite exploiter le potentiel de l’IA générative en tant qu’assistant tuteur afin de favoriser l’individualisation de l’accompagnement et d’intensifier la fréquence des évaluations formatives. Cette approche vise également à instaurer une culture du feedback au sein des formations.

L’évaluation scientifique du projet sera menée par l’Observatoire de la Transformation Pédagogique (OTP), qui analysera l’impact de l’évaluation par les pairs assisté par l’IA sur les pratiques pédagogiques et sur l’apprentissage des étudiants.

Une expérimentation menée dans un cours en MMI à l’IUT de Béziers

Dans le cadre de la mise en place du projet PAIRSIA, l’IA de ChallengeME a été testée auprès des étudiants du BUT Métiers du Multimédia et de l’Internet (MMI) de l’IUT de Béziers. Cette première expérimentation s’est déroulée dans le cadre d’une SAé (situation d’apprentissage et d’évaluation) lors de laquelle les étudiants devaient améliorer leur page LinkedIn. Ils avaient le choix d’activer ou non l’assistant IA.

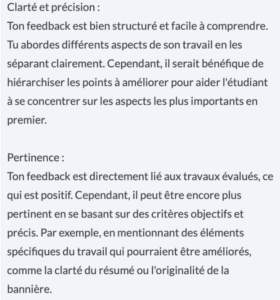

Deux captures d’écran illustrent le rôle de l’assistant, qui n’écrit pas à la place des étudiants, mais leur fournit des pistes d’amélioration précises et adaptées.

L’assistant IA pour l’évaluation par les pairs vous intéresse ? Vous pouvez d’ores et déjà l’utiliser dans ChallengeMe (accessible dans Moodle) ou prendre contact avec le Service des Usages du Numérique pour être conseillé sur son intégration dans votre enseignement.

Vous pouvez par ailleurs profiter des ressources sur l’évaluation par les pairs créées dans le cadre du projet Pair’sEval.

BIBLIOGRAPHIE

Tai, J., Ajjawi, R., Boud, D. et al. (2018). Developing evaluative judgement: enabling students to make decisions about the quality of work. High Educ 76, 467–481. https://doi.org/10.1007/s10734-017-0220-3

Topping, K.J. (2017). Peer Assessment: Learning by Judging and Discussing the Work of Other Learners. Interdisciplinary Education and Psychology, 1(1):7.

Topping, K. J. (2009). Peer assessment. Theory into Practice, 48, 20-27. DOI : 10.1080/00405840802577569